대부분의 권위 있는 국제 학술단체나 저널은 AI 도구(tool)를 저자로 표시하는 것을 인정하지 않고 있으며, 윤리적·법률적 측면을 고려하여 인간만이 저자로 표시될 수 있다는 점을 명시하고 있는 것으로 조사됐다.

최근 이미 많은 연구자들이 일련의 연구개발 수행과정에서 ChatGPT와 같은 AI 도구를 사용하고 있다. 이 기술은 조만간 실험설계, 논문 원고 작성 및 완성, 논문 원고 수락 또는 거절을 위한 피어리뷰 진행 및 편집 결정 지원 등이 가능한 지점까지 진화할 것으로 예측되고 있다. 이러한 것이 실현된다면, 정부가 지원하는 연구개발 과제의 기획 및 선정, 평가에서도 AI 도구의 활용이 급속히 진전될 것이다.

이에 한국연구재단은 기존의 연구윤리, 즉 연구진실성 관점에서 AI 도구를 활용한 결과물의 연구윤리 이슈와 관련된 최근 동향을 살펴본 이슈 리포트 〈연구개발에서 인공지능 도구의 활용과 관련된 연구윤리 이슈 분석〉(저자: 김해도 연구윤리지원센터장·양정모 윤리정책팀장)을 8월 8일 발간했다.

보고서에 따르면, 연구개발 수행과정에서 ChatGPT와 같은 AI 도구의 활용이 급속히 증가함에 따라 학술적 측면에서 일부 저널이나 프리프린트에서 ChatGPT를 저자로 표시하는 것을 허용하는 사례도 등장하고 있다. 그러나 AI 도구는 연구결과물에 대한 책임을 지지 못하고 법인격이 없기 때문에 저자가 될 수 없다는 것이 세계 주요 학술단체들의 입장이다. 법률적 측면에서도 세계 각국이 현재까지 ChatGPT와 같은 AI 도구를 발명자(Inventor)나 저작자(Author)로 인정한 사례는 없다.

즉, AI 도구를 학술적(또는 윤리적)·법률적 측면에서 창작의 주체로 인정하지 않고 인간의 보조 수단 정도로만 인정하고 있다. 그 이유는 현행 학문 및 법률 체계가 인간을 중심으로 규범화되어 있고, AI 도구의 인지능력이 아직까지는 강 인공지능(strong AI; general AI 일반 인공지능)에 도달하지 못했기 때문이다.

따라서 아직은 현행 학계관행, 연구윤리규범, 법률체계로도 AI 도구의 활용과 관련된 연구윤리 이슈(위조, 변조, 표절, 부당저자표시 등)에 대응할 수 있다. 하지만 AI 도구의 활용으로 인한 교묘한 일탈문제에 효과적으로 대응하기 위한 분석 및 검색 도구의 지속적 개발과 AI 도구의 활용과 관련된 보다 세부적인 연구윤리 가이드 마련은 시급한 과제이다.

현행 AI 개발 속도를 보면 가까운 미래에 AI 도구의 인지능력이 고도화되어 인간의 조력 없이도 스스로 판단하고 새로운 것을 창조하는 시대가 올 수도 있다. 보고서는 이러한 미래를 대비하여 연구윤리규범과 법률체계를 어떻게 인간중심으로 재설계할지를 지금부터 고민하고 준비해야 하며, 이와 더불어 산업 혁신을 촉진하기 위한 수단으로 AI를 창작의 주체로 인정하는 법률 정비가 필요한지에 대해서도 체계적인 검토가 필요한 시점이라고 제언했다.

◇ 보고서의 주요 내용은 다음과 같다.

■ 인공지능과 연구윤리

인공지능, 기후변화, 미래직업 등을 전문적으로 다루고 있는 영국의 News website인 Tortoise Media가 2023년 6월 28일 발표한 ‘2023 Global AI Index’에 따르면 한국의 AI 종합경쟁력은 세계 6위 수준인 것으로 나타났다. 이 중에서 AI의 개발 부분(AI 관련 플랫폼, 알고리즘 등)의 경쟁력은 미국과 중국에 이어 세계 3위 수준인 것으로 평가됐다.

이처럼 우리나라의 AI 경쟁력이 세계적 수준에 도달하고 있으므로, AI 도구의 활용과 관련된 연구윤리 준수도 글로벌 기준에 부합해야 한다. 그러나 이 부문에 대한 연구와 윤리 가이드 마련은 아직 시작단계이다.

▶ 인공지능과 윤리기준

◦ ‘인공지능 윤리기준’이란 인공지능의 개발과 활용 전반의 과정에서 고려해야 할 각종 요소를 말한다. 법률은 아니지만, 정부기관, 인공지능 개발기업과 이용자 등 인공지능기술 이해관계자 모두가 지켜야 할 사회적 규범의 성격을 띠고 있다.

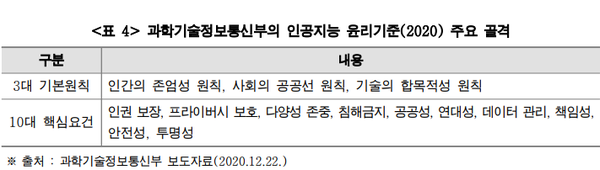

◦ 우리나라 과학기술정보통신부는 2020년에 인공지능 윤리기준이 지향하는 최고 가치를 인간성(Humanity)으로 설정하고, 인공지능 개발 및 활용의 3대 기본원칙과 10대 핵심요건을 제시했다.

◦ 전 세계 여러 학술단체들과 정부기관이 발표한 AI의 책임 있는 개발과 활용에 대한 일반적인 지침(윤리기준)의 핵심요소는 accountability(설명책임: 비차별성, 공정성), responsibility(역할책임: 인간주체성, 감독), transparency(투명성: 기술적견고성, 데이터관리) 등 3가지로 요약된다.

▶ 인공지능 활용 관련 연구윤리

◦ ‘인공지능 활용 관련 연구윤리’는 다양한 학문 및 기술 분야의 연구개발 활동 수행과정에서 인공지능 도구를 활용하는 경우 준수해야 할 윤리기준을 말한다. 이 연구윤리 기준은 다양한 분야의 연구개발 및 학술활동 수행과정에서 AI기술의 활용에 따른 위조, 변조, 표절, 부당저자표시 등 연구부정행위를 예방하고 바람직한 연구 관행을 만들어 연구진실성을 확보하는 것에 초점이 맞추어져 있다.

▶ 인공지능과 지식재산권

∎ 인공지능과 저작권

① AI 도구를 활용하여 만든 결과물은 저작권법상의 보호대상 저작물인가?

◦ 저작권의 보호 근거는 국제조약과 각국의 저작권법에 따르게 되는데, 아직까지는 인간이 아닌 존재가 만든 결과물을 저작권으로 보호하는 입법 사례는 없다. 한국과 미국의 저작권법 관점에서 볼 때 AI도구를 활용하여 만든 결과물 그 자체는 인간의 사항이나 감정을 표현한 것이 아니므로 저작권법에 따른 보호대상에 속하지 않는다.

② AI 도구는 저작자로 표시될 수 있는가?

◦ 현행 전 세계 저작권법은 인간이 창작한 결과물에 대해서만 저작권을 보호하고 있기 때문에 AI 도구가 만든 저작물에 대해 해당 AI 도구에 대한 저작인격권은 성립하지 않는다. 권리와 책임의 주체가 될 수 없는 AI 도구를 저작자로 표시하는 것은 적절하지 않다.

③ AI 도구를 활용하여 만든 결과물이 저작권 보호를 받기 위한 요건을 무엇인가?

◦ AI 도구가 생성한 저작물(텍스트, 이미지, 음성 등)들도 특정한 조건이 부가되면 제한적인 범위 내에서 저작권이 보호될 수 있다. 예를 들어 AI도구가 생성한 저작물에 인간의 저작물이 부가된다면 부가된 부분에 대해서 저작권이 인정될 수 있고, AI 저작물들이 창의적으로 재배열된 경우라면 재배열한 것에 대한 저작권이 인정될 수 있다. 그러나 이러한 경우에도 AI 도구가 생성한 저작물 자체는 저작권이 인정되지 않는다.

∎ 인공지능과 특허권

◦ AI 도구를 활용하여 완성된 발명은 해당 국가의 특허법이 제시한 요건(한국의 경우, 신규성, 진보성, 산업상 이용 가능성 등의 요건을 충족해야 함)을 충족하고 소정의 심사과정을 통과하면 특허권을 취득할 수 있다.

◦ 최근 세계 각국에서 AI도구를 활용하여 만든 발명과 관련하여 “AI도구가 발명자가 될 수 있는가?”에 대한 논쟁이 매우 치열하다. 세계 각국의 특허법은 산업진흥정책의 산물이기 때문에 ‘인공지능의 발명자 적격 여부’에 대한 각국의 현행 태도가 고정적이라고 볼 수는 없다. 이는 각국의 산업정책 필요에 따라 인공지능에 대해 발명자 지위를 부여하거나 현행 특허법 해석기준을 확장하여 인공지능에게 발명자 지위를 부여하는 것은 얼마든지 가능하기 때문이다. 물론 인공지능의 권리 및 의무와 관련된 사회적 합의가 전제되어야 한다.

■ 인공지능 활용 관련 연구윤리에 대한 주요 학술단체의 입장

▶ Nature誌(모든 Springer Nature journals 포함)

◦ Nature誌는 2023년 1월 24일 사설을 통해 LLM(Large Language Models) tool의 윤리적 사용과 관련된 2가지 원칙을 다음과 같이 제시했다.

▶ Science誌

◦ Science誌는 편집 정책(Editorial Policies)에서 다음과 같이 AI가 저자가 될 수 없음을 밝히고 있다.

▶ 세계의학편집인협의회(WAME: World Association of Medical Editors)

◦ WAME는 2023년 1월 20일 “학술출판에서 챗GPT 및 챗봇 사용에 관한 권고사항(WAME Recommendations on ChatGPT and Chatbots in Relation to Scholarly Publications)”을 발표한 바 있으나, 최근 챗봇 사용이 폭발적으로 증가함에 따라 2023년 5월 31일 동 권고사항의 개정판을 발표했다. 개정판에 따른 권고사항은 5가지로 요약할 수 있다.

• 첫째, 인간만이 저자가 될 수 있다(Only humans can be authors).

• 둘째, 저자는 자료의 출처를 밝혀야 한다(Authors should acknowledge the sources of their materials).

• 셋째, 저자는 연구결과에 대한 공식적 책임을 져야 한다(Authors must take public responsibility for their work).

• 넷째, 편집자와 리뷰어는 논문 원고에 대한 평가와 리뷰의견 작성 및 교신과정에서 챗봇을 사용한 경우 이를 명시해야 한다(Editors and reviewers should specify, to authors and

each other, any use of chatbots in evaluation of the manuscript and generation of reviews and correspondence).

• 다섯째, 편집자는 출판에서 챗봇의 영향을 처리하기 위해 필요한 적절한 디지털 도구를 갖추어야 한다(Editors need appropriate digital tools to deal with the effects of chatbots on publishing).

▶ 국제의학학술지편집인위원회(ICMJE: International Committee of Medical Journal Editors)

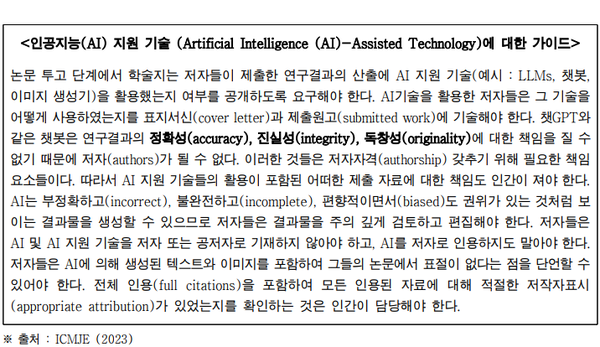

◦ ICMJE는 2023년 5월 개정판 권고사항에 인공지능(AI) 기술의 도움을 받아 수행된 연구결과물의 저자 및 기여자 표기 등에 대한 가이드를 다음과 같이 신설했다. 주요 골자는 AI는 정확성·진실성·독창성에 대한 책임을 질 수 없기 때문에 저자가 될 수 없다는 점이다.

▶ 미국의학협회저널네트워크(JAMA Network: Journal of the American Medical Association)

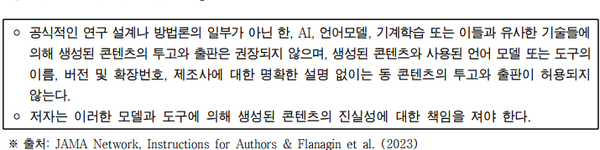

◦ JAMA와 JAMA 네트워크 저널들은 AI 및 유사 기술들은 저자로 표시될 수 없고, AI 기술이 논문 작성 등에 활동된 경우 이로 인한 연구진실성은 저자가 책임을 져야 한다는 입장을 밝히고 있는데 주요 내용은 다음과 같다.

① 저자 책임(Author Responsibilities)

② 재생 및 재창작된 자료(Reproduced and Re-created Material)

③ 이미지 진실성(Image Integrity)

▶ 국제학술지출판윤리위원회(COPE: Committee on Publication Ethics)

◦ COPE은 출판윤리에 관심을 가진 사람과 단체의 모임으로 1997년에 학술지 편집자들의 자발적 모임으로 시작되었다. 이 단체의 주요 회원은 학술지 편집자들이나 출판사, 대학, 연구소, 출판윤리와 관련된 단체와 개인들도 회원으로 참여하고 있다.

◦ 2023년 2월 13일 COPE은 AI tool의 사용과 관련된 저자표시 등에 대해 세계의학편집인협의회(WAME)와 미국의학협회저널 네트워크(JAMA Network)와 같은 단체의 입장을 지지한다고 밝혔다.